アップル「超絶ゴーグル」体験でわかった10のこと

2023.06.09

東洋経済オンライン

2. 誰でも簡単「見てつまむ、インターフェース」

装着すると、まず視線入力の登録作業を行う。画面に現れる6つの点を目で追いかける作業を2度繰り返しておしまい。こちらも1分ほどで終わる。続いて、操作に使う手の登録作業。こちらも一瞬で終わってしまい、使い始める初期設定が完了する。

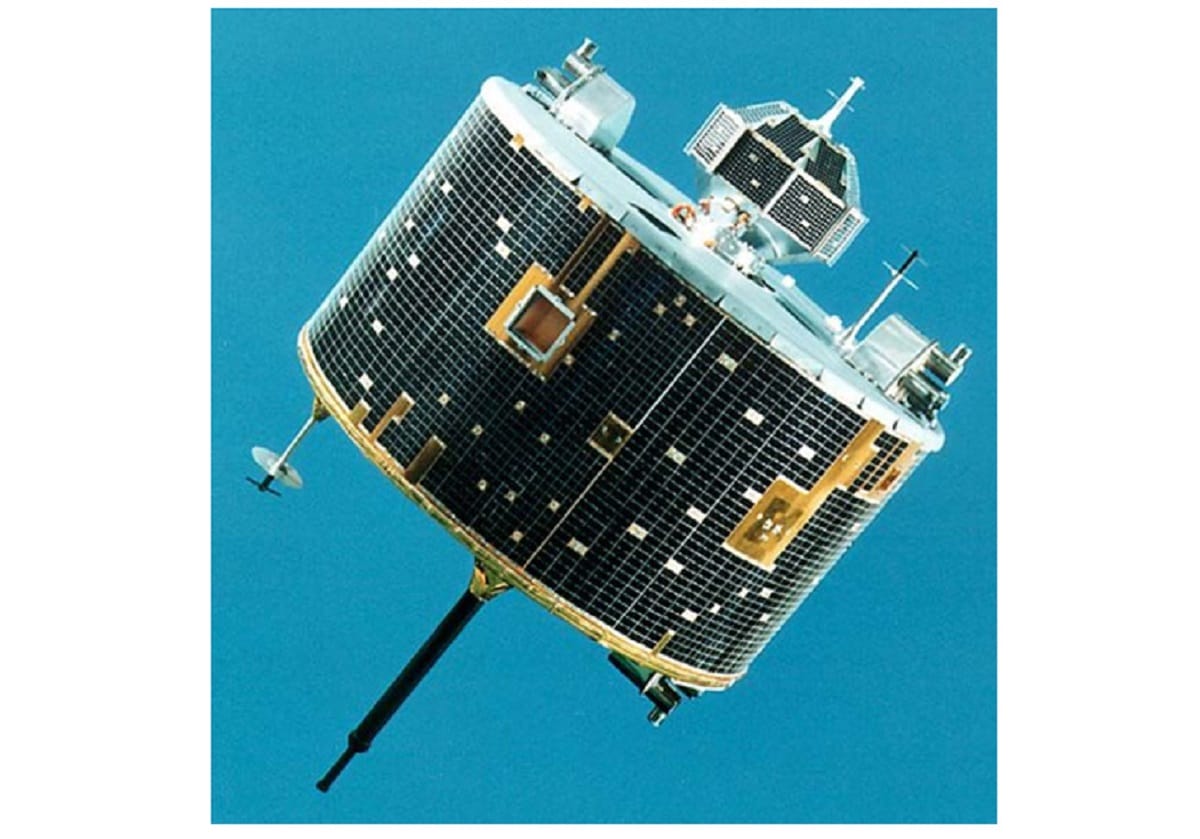

視線のトラッキングは、ゴーグルの内側のセンサーとカメラを通じて行われる。6つの点を2回見る1分程度の設定作業ですぐに使いこなすことができる(画像:アップル公式サイトより)

Apple Vision Proは、コントローラーなどを使わず操作する。操作したい対象を見て(視線を送り)、親指と人差し指でつまんで離せば、スマホやパソコンでいうところの「タップ」の操作。つまんだまま動かせば、ドラッグやスワイプといった操作になる。

ゴーグルの前方だけでなく下向きにもカメラが備わっており、座っている状態で、ももの上に置いた手でつまむ操作をしても認識してくれる。またつまんだまま動かす動作は、上下左右だけでなく前後の動きもできる。

今までのパソコンやスマートフォンは、「見る」動作と「操作する」動作が分離していた。見て→操作するという手順だった。特にパソコンのマウスは、操作したい対象と、操作するポインターの位置の双方を見なければならないため、慣れが必要だった。

しかしApple Vision Proは、見たものをつまむため、見る動作が操作の一環となっており、また指の位置を問わないため、より直感的なユーザーインターフェースになっているのだ。

肉眼と同じ感覚で行動できる

3. 最大の優位性「現実世界の再現性が極めて高い」

Apple Vision Proを装着してまず最初に、そして最も感動したのが、カメラとディスプレーを通して見ている現実世界が、肉眼で見ている状態と同じ感覚で行動できるという点だった。

MacBook Airと同じM2チップに加えて、12のカメラ、5つのセンサー、6つのマイクから入ってくる情報をリアルタイムに処理するためのR1チップが備わり、肉眼と同じ感覚を画面の中に作り出している(画像:アップル公式サイトより)

ディスプレーを通した映像で発生しがちだった、反応の遅延や、手を伸ばしたときの距離感や位置のずれが感じられない。装着したままでも、机やイスを正確に避けることができ、コップをズレなく掴むことができ、手元の紙のノートにペンで正確にメモを取ることもできる。ゴーグルをつけたままでも、極めて安全に歩き回ることができる。

実空間をApple Vision Proを通じて正確に見ることができるため、その中に配置したウインドーや3Dオブジェクトも、位置や高さなどが非常に正確に再現され、一度置いたら首を振って視野を変えたり、歩き回ってまた戻ってきても、ビシッとその場所にあり続ける。奥行きの位置関係に応じて、物体の前に回り込んだり、後ろに回り込んだり、といった処理もスムーズに行われていた。

Digital Crownを回すと、現実世界と仮想世界の境界を調節することができる(画像:アップル公式サイトより)

ゴーグル部分の右上にあるDigital Crownを回すと、現実世界と仮想世界の境界を調節することができ、現実世界の視界をシャットアウトして完全に没入感に浸ることができる。しかし左右から人が話しかけてくると、その人がぼんやりと浮かび上がり、会話することができる。

今回のデモでは確認する術がなかったが、話し始めると、相手には装着している自分の「目」が、外向きのディスプレーに映し出されるはずだ。

4. ディスプレーの品質は?