話題の「ChatGPT」、そのすごさと″限界"のワケ

2023.03.15

東洋経済オンライン

ChatGPTの仕組みについて解説します(画像:metamorworks/PIXTA)

昨年末にChatGPTという、大規模自然言語AIモデルを用いたチャットサービスが公開されると、IT業界はもとより一般のビジネスパーソンにも、その自然な応対に驚きの声が広がった。一方で現在のAI技術には限界もある。

本稿では、ChatGPTのすごさと限界、そしてその理由を探ることで、AIを「シゴトの道具」として使うためのヒントを探すことにしたい。

GPTが「驚き」をもたらした背景

ChatGPTは誰もが利用できるため、「一体何?」という方は、まず自分でChatGPT公式サイトにアクセスしてみることを勧める。百聞は一見に如かず。予備知識なしに使った人の多くは少なからず驚き、中には人間的な応対をAIが行うことに畏怖の念を覚える人も多いだろう。

なぜこのように自然な会話ができるチャットサービスが生まれたのか。

まずはその経緯や仕組みへの理解を深めておきたい。技術的な知識は必要ないが、どのように動いているのか概略を知っていると、AIを使いこなす際には大きなヒントとなる。

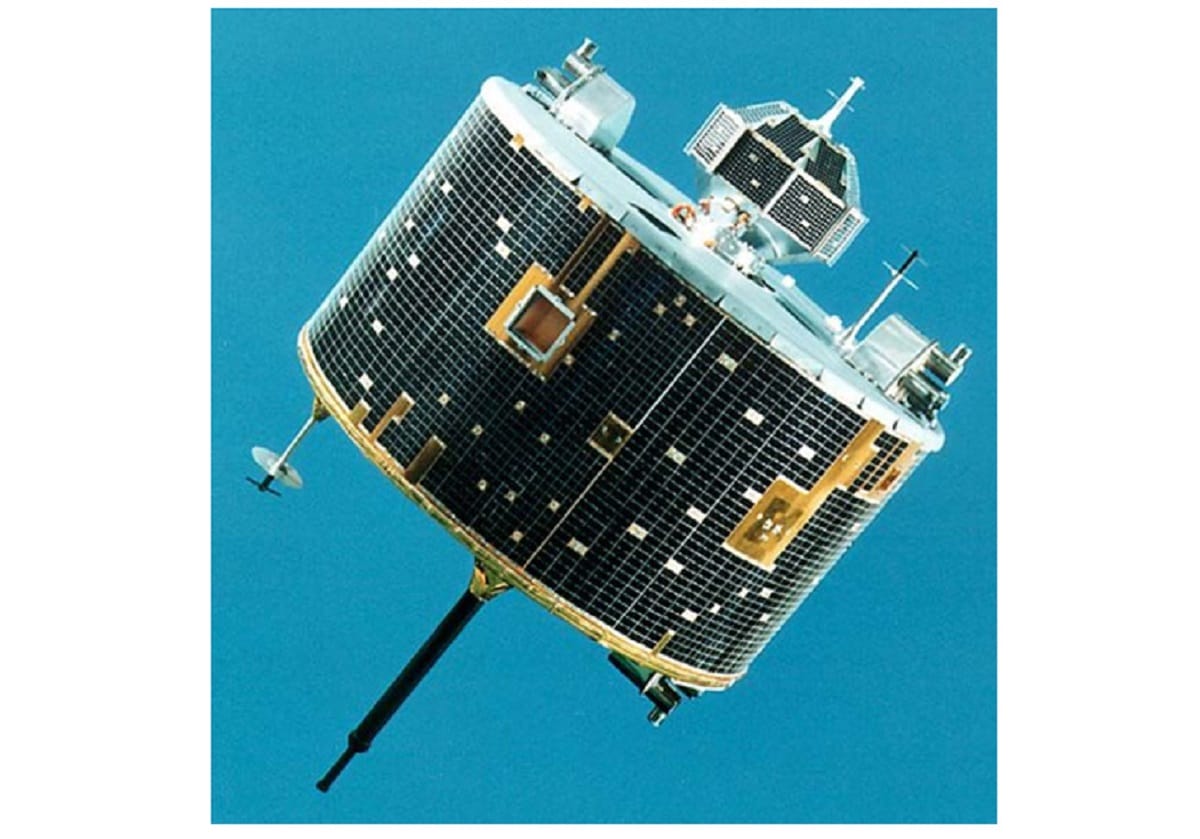

ChatGPTの公式サイトにアクセスして質問を入力するとこのように答えが返ってくる。有料のPlusもあるが基本的には誰でも利用可能(筆者撮影)

ChatGPTの基礎になっているのはOpenAIのGPT(Generative Pre-trained Transformer)という技術だ。「T」の部分、すなわち「Transformer」とは、連続するデータ列の関係性を追跡し、データの登場する順番やパターンなどを学習していくことで、文脈や意味を学習させようというニューラルネットワーク処理だ。

ニューラルネットワークというのは、人間の脳の働き方を模したコンピューター処理の手法だと考えればいい。

世の中にある単語の列や関係性を大量に学習させることで、その関係性から的確な要約文を生成したり、意味の通る文章となるよう選ぶ単語列の推論を行おうという試みだ。詳細はネット上に大量の資料があるため、ここではこれ以上掘り下げないが、GPTはこの考え方で開発されたニューラルネットワークに、OpenAI独自のパラメータで事前学習させておくことで、自然な文章を生成可能にしたものだ。

OpenAIはGPTの開発で作り上げたニューラルネットワークを改善しつつ、主にパラメータ数を(それも常識はずれに)増やしていくことで質を高めようと試みた。

パラメータとはAIが動作し、結果を導き出す際に「どの選択肢が確率的に高いか」を推しはかるために参照する要素のことだ。同じ学習データを用いて深層学習を行ったとしても、パラメータが増加すれば結果を導き出す際の分岐点が増えて、より多彩で複雑な回答を得られる。

パラメータの増加とは?

誤解を恐れずに思い切りシンプルに説明するならば、パラメータが増加することで「正しい選択肢」へと向かう枝が多岐にわたるようになり、与える課題のちょっとした違いによって多様で細かな違いを反映させた複雑で奥行きを感じさせる結果(文章)を出力する。

OpenAIの場合、初期段階で1億1700万だったパラメータをGPT-2では15億にまで増やした。良好な結果が得られたため、GPT-3では1750億にまでパラメータを増やしている。ChatGPTで使われているGPT-3.5では、3550億とさらに2倍の規模となった。

それまでのAIが生成する文章には、どこかしら不自然さ、単調さがあった。

ところが、この超大規模パラメータ化によって、その言葉の選び方が「まるで人間が作ったかのように感じる」レベルにまで達し始めた。